浅浅用的环境是:

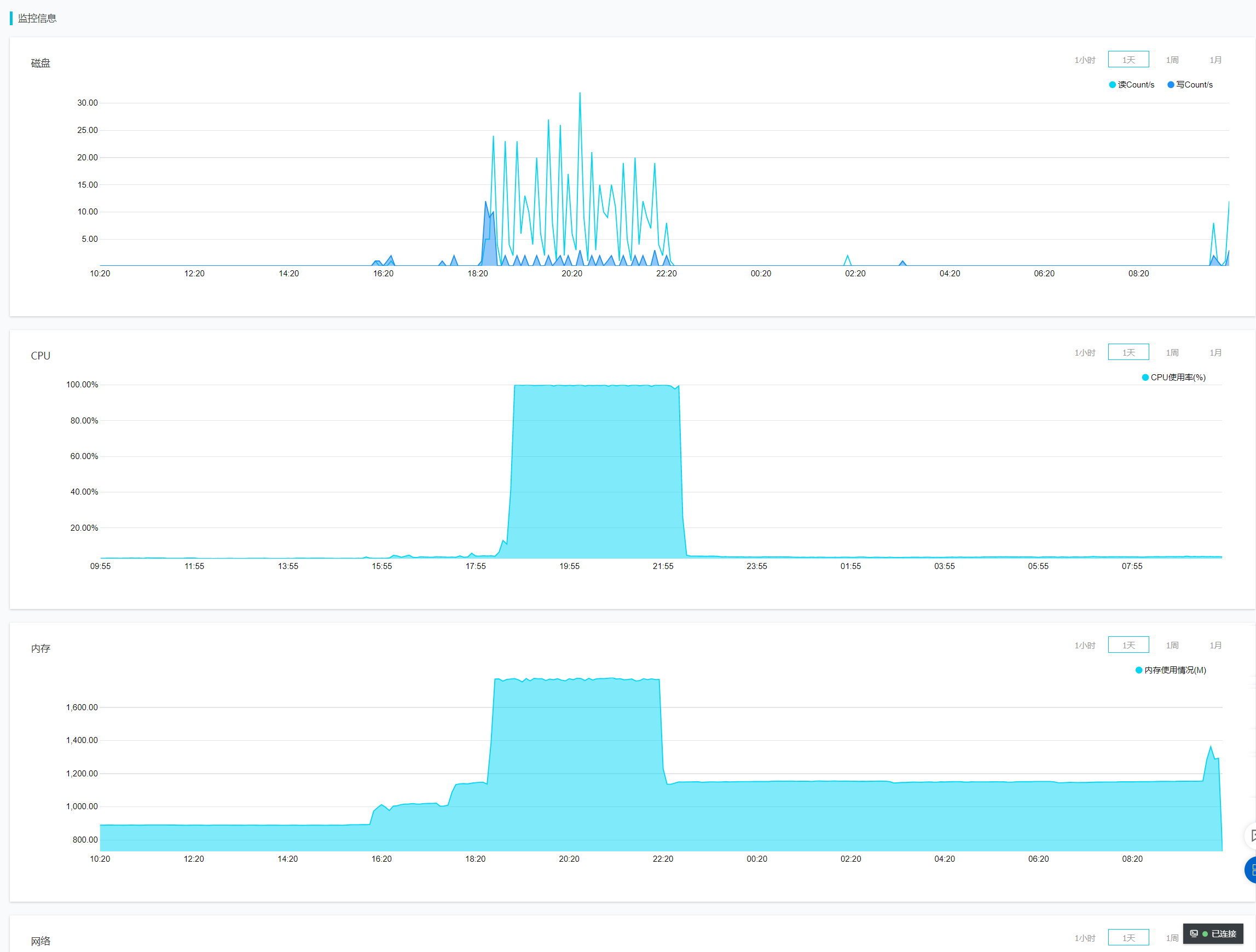

阿里云轻量型服务器 1核2G 40GBSSD

系统为CentOS7.3

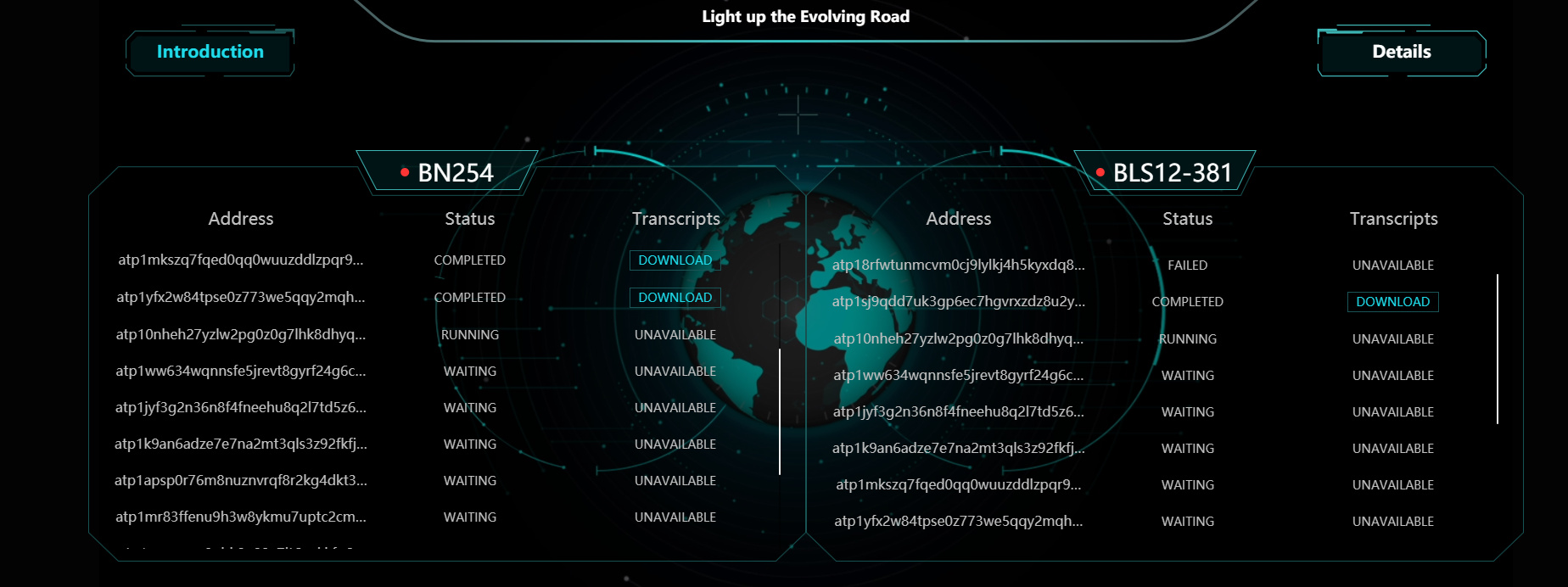

要记得去发邮件申请,申请通过后,再次确认你的ATP地址有效,回复邮件即可。

好了,现在开始讲操作步骤

-----------------------------------------------温柔的分割线--------------------------------------------

第一步:买一台阿里云服务器,学生党一年只要89块。或者用自己的机器也可以,我没用自己的机器,欢迎大佬补充。

第二步:远程连接上云服务器之后,sudo su root 进入管理员权限,然后参考这篇博客安装docker。阿里云CentOS安装Docker。

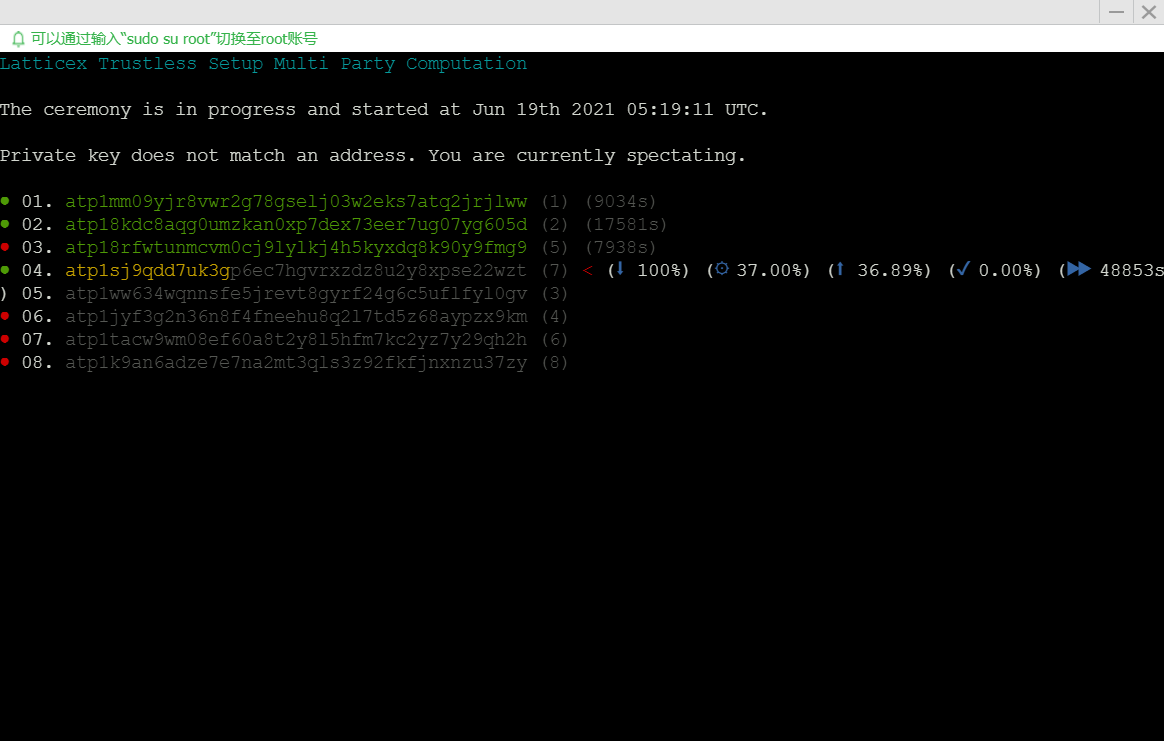

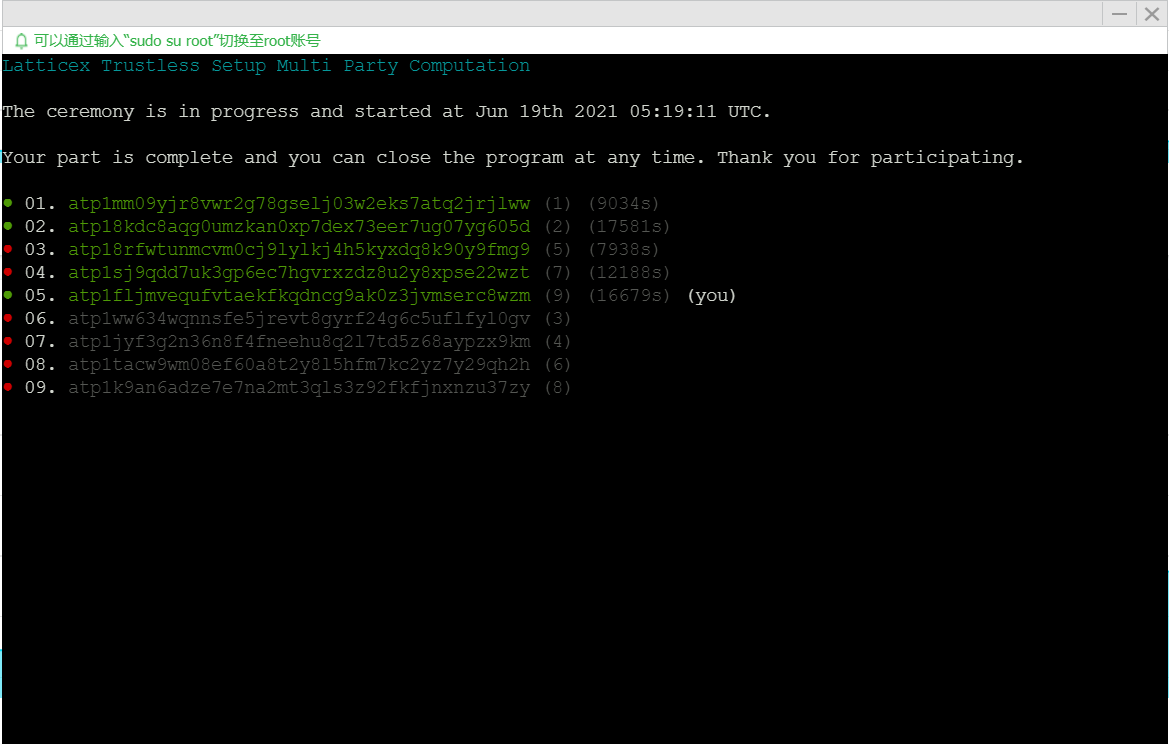

第三步:安装好之后,看GitHub上官方lumino仓库的setup-mpc-client文件夹里的ReadMe.md,按照操作一步步来执行即可完成。

备注:记得一定要先去查看你的docker images,获得到images id之后,再进行其中的sudo docker tag操作。然后这里提供的示例中,存在于一个私钥,按照Larry大佬给的回复,是ATP地址的私钥前置加上0x,然后回车运行即可。